Como funciona a memória RAM?

Por Igor Pankiewicz em 28/8/2009

Neste artigo, você aprenderá um pouco mais a respeito do funcionamento deste componente tão vital para os computadores. De especificações e funções até os diferentes tipos que existem atualmente.

Processadores, placas mãe, discos rígidos, ventoinhas, placas de som... Gabinetes podem ser inteiriços por fora, mas por dentro existe uma série de componentes. Alguns deles podem até não ser requeridos para o funcionamento de um sistema operacional (como drives de CD ou DVDs, por exemplo), mas existem outros sem os quais a máquina nem ligará!

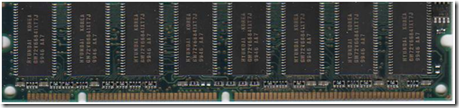

Um deles é a memória RAM, essencial no processamento e armazenamento dos seus programas, atuando em conjunto principalmente com o seu processador. Hoje, nós mostramos a vocês um pouco mais sobre elas, desde a composição, tipos, tamanhos, velocidades até o modo como operam em conjunto com os demais componentes

Um deles é a memória RAM, essencial no processamento e armazenamento dos seus programas, atuando em conjunto principalmente com o seu processador. Hoje, nós mostramos a vocês um pouco mais sobre elas, desde a composição, tipos, tamanhos, velocidades até o modo como operam em conjunto com os demais componentes

Está curioso? Então não deixe de conferir!

O que significa RAM

O termo é um acrônimo para Random Access Memory, isto é, memória de acesso aleatório. Isso implica que esta memória pode acessar os dados de forma não sequencial (ao contrário de uma fita cassete, por exemplo), acelerando em muito os processos de leitura e escrita. Qualquer

setor livre ou já preenchido é imediatamente encontrado e processado.

Entretanto, ao contrário de um disco rígido, a memória RAM é totalmente volátil, o que significa que todos os dados armazenados podem ser perdidos quando o dispositivo não é devidamente alimentado. Mas se há este contratempo, saiba que ela é milhares de vezes mais rápida que a varredura do disco físico.

Memória RAM em dois “sabores”

Antes de tudo, você precisa saber que existem dois tipos básicos de RAM, que são a memória estática e a memória dinâmica. A primeira pode ser menos reconhecida pelo público em geral, mas está presente em muitos componentes de nossos computadores, principalmente nos processadores, onde formam a memória cache (nós explicaremos o conceito mais abaixo, durante a ilustração do percurso de funcionamento da memória RAM).

Antes de tudo, você precisa saber que existem dois tipos básicos de RAM, que são a memória estática e a memória dinâmica. A primeira pode ser menos reconhecida pelo público em geral, mas está presente em muitos componentes de nossos computadores, principalmente nos processadores, onde formam a memória cache (nós explicaremos o conceito mais abaixo, durante a ilustração do percurso de funcionamento da memória RAM).

A memória estática é composta por flip-flops* (montados com quatro a seis transistores) e não necessita ser atualizada constantemente, o que a torna muito mais rápida e eficiente para trabalhos que requerem baixa latência. Os estados de saída podem ser 0 ou 1, sendo perdidos apenas quando o fornecimento de energia é cortado.

Em contrapartida, ela ocupa um espaço físico muito maior, sendo impraticável a construção de pentes de memória para uso tradicional. Outro problema é o custo bem mais elevado.

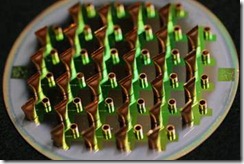

Já a memória RAM dinâmica, ou DRAM, é a que vemos para comprar nas lojas e que equipam nossas placas mãe. Suas células são compostas por um capacitor e um transistor, sendo o transistor uma espécie de portão (que barra ou dá passagem ao pulso elétrico) e o capacitor o responsável por armazenar a informação (novamente, estados de 0 ou 1).

Uma vez que o capacitor se descarrega ao longo do tempo, é necessário mantê-lo sempre alimentado. Estes circuitos integrados são dispostos em forma de linhas e colunas, de tal forma que os dados possam ser acessados, lidos ou escritos por meio de interseções (imagine uma posição A3, ativada por um pulso elétrico na linha A e por outro na coluna 3).

Este formato pode ser mais barato e compacto em relação à memória estática (abrigando muito mais capacidade de armazenamento por centímetro quadrado), mas — em contrapartida — devido a necessidade de localização de posições, da constante alimentação e da própria mudança de estado levam a uma latência maior para a leitura.

Este formato pode ser mais barato e compacto em relação à memória estática (abrigando muito mais capacidade de armazenamento por centímetro quadrado), mas — em contrapartida — devido a necessidade de localização de posições, da constante alimentação e da própria mudança de estado levam a uma latência maior para a leitura.

Caso deseje saber mais sobre estes dois diferentes tipos de memória, não deixe de conferir o artigo “Qual a diferença entre memória RAM estática e dinâmica”, no qual o assunto é abordado de maneira mais extensa.

A ordem dos fatores

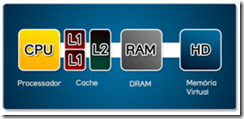

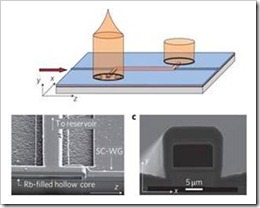

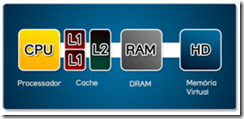

Agora que você já sabe um pouco mais a respeito do funcionamento destes componentes, vamos ao percurso das informações pelos componentes e ao papel crucial das memórias. Tudo começa com os cálculos da CPU (unidade de processamento central, ou processador), que são realmente volumosos.

Todos estes dados processados podem ser requisitados para uma operação futura, entrando em cena a necessidade de um componente que armazene temporariamente as informações. Temos então as memórias cache, RAM e o próprio disco rígido atuando como um único sistema.

Como o volume de dados é gigantesco (passando da ordem de bilhões de bytes por segundo), é necessária, em primeiro lugar, uma memória extremamente rápida, capaz de acompanhar este ritmo frenético. A solução para isso é a memória cache (um tipo de memória estática, como já vimos), que fica acoplada diretamente no processador, fornecendo um espaço de trabalho com o mínimo de latência possível

Esta memória cache também é dividida em vários níveis (tais como L1, L2, L3 e assim por diante), sendo L1 a mais próxima do processador e as demais as mais afastadas, com capacidades maiores e maiores latências, mas ainda assim com um canal direto de comunicação, permitindo acesso praticamente imediato aos dados.

Esta memória cache também é dividida em vários níveis (tais como L1, L2, L3 e assim por diante), sendo L1 a mais próxima do processador e as demais as mais afastadas, com capacidades maiores e maiores latências, mas ainda assim com um canal direto de comunicação, permitindo acesso praticamente imediato aos dados.

Recorrendo ao plano B

Mas com um espaço tão pequeno, o que ocorre quando o dado não é comportado? Entra em cena então o próximo nível na hierarquia de memória e de acesso (por meio do controlador de memória), que é a utilização da memória DRAM (memória dinâmica, a encontrada nos pentes que estão na sua placa mãe).

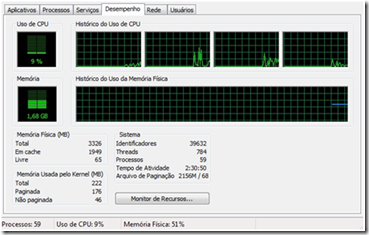

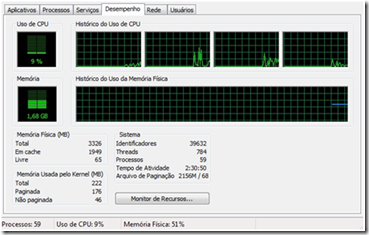

Nela é que residem todos os dados abertos pelo sistema (bem como os processos que estão em atividade), como os programas e arquivos. Para conferir melhor a atuação delas, experimente abrir o gerenciador de tarefas do Windows. Na tela estão todas as taxas de utilização de memória dos programas, seguidas do total disponível em sistema.

Novamente, dependendo da utilização que você faça do seu sistema, pode ser que a memória DRAM disponível nos pentes não seja suficiente para abastecer todas as necessidades do seu sistema. E nesses casos, como fazer para que o computador não emperre?

Novamente, dependendo da utilização que você faça do seu sistema, pode ser que a memória DRAM disponível nos pentes não seja suficiente para abastecer todas as necessidades do seu sistema. E nesses casos, como fazer para que o computador não emperre?

Hora do plano... C?

A resposta está no disco rígido, que passa a ser utilizado pela maioria dos sistemas operacionais atuais como uma extensão da memória RAM, sob a forma de uma memória virtual. Assim, o sistema passa a ler e escrever dados em disco, evitando travas e continuando o gerenciamento dos processos.

A resposta está no disco rígido, que passa a ser utilizado pela maioria dos sistemas operacionais atuais como uma extensão da memória RAM, sob a forma de uma memória virtual. Assim, o sistema passa a ler e escrever dados em disco, evitando travas e continuando o gerenciamento dos processos.

Só há um grande problema com isso: a velocidade de leitura e escrita é muito inferior à encontrada

para os outros tipos de memórias do mercado. Como resultado, seu PC continuará em funcionamento, mas o desempenho... Estará lá em baixo!

O sistema tentará trocar os dados na maior velocidade possível, armazenando na RAM tudo o que for mais importante, deixando para o HD os itens de menor importância. Mesmo assim, janelas irão travar e o mouse ficará pesado!

Usuários com mais conhecimento podem configurar quanto de seus discos rígidos poderão atuar nesta virtualização, de modo a obterem o máximo de desempenho sob tais circunstâncias. Para saber mais sobre a memória virtual e a aplicação dos HDs, não deixe de ler o artigo “O que é memória virtual”.

Usuários com mais conhecimento podem configurar quanto de seus discos rígidos poderão atuar nesta virtualização, de modo a obterem o máximo de desempenho sob tais circunstâncias. Para saber mais sobre a memória virtual e a aplicação dos HDs, não deixe de ler o artigo “O que é memória virtual”.

Tipos de memórias

Nós já cobrimos um pouco do caminho dos dados pelo computador, então vamos aos tipos de pentes que encontramos no mercado ou que já existiram e deixaram de ser vendidos. Vale lembrar que os equipamentos e processadores mais recentes trabalham com memórias do tipo DDR2 ou DDR (para alguns dos anos anteriores). E para descobrir qual é o tipo de memória utilizada pelo seu computador, siga diretamente para o manual de instruções.

Memória SIMM - O termo SIMM vem de Single In-Line Memory Module, e era designado ao tipo de módulo de memória utilizado em computadores até meados da década de noventa. Os primeiros modelos conseguiam carregar as instruções com apenas 8 bits a cada passagem, tendo um total de 30 pinos conectores. Depois de algum tempo, surgiram novos módulos, os quais continham 72 pinos de conexão e suportavam até 32 bits de informação por acesso.

Memória DIMM - DIMM - Dual Inline Memory Module (Módulo de Memória em Linha Dupla), encapsulamento, é um dos tipos de memória DRAM. As memórias DIMM estão divididas basicamente em dois tipos: as SDR SDRAM e DDR SDRAM. São classificadas também de acordo com a quantidade de vias que possuem, por exemplo, a SDR SDRAM que possui 168 vias e a DDR SDRAM que possui 184 vias. Ao contrário das memórias SIMM, estes módulos possuem contatos em ambos os lados do pente, e daí lhes vem o nome (DIMM é a sigla de Dual Inline Memory Module). São módulos de 64 bits, não necessitando mais utilizar o esquema de ligação das antigas SIMM (Single Inline Memory Module), a paridade. São comuns módulos de 64 MB, 128 MB, 256 MB, 512 MB, 1 GB, 2GB atualmente.

Estes módulos entraram no mercado para substituir os pentes mencionados acima, principalmente com a ascensão da arquitetura Pentium no mercado mundial de computadores. As grandes diferenças consistem no fato de que ambos os lados de conectores são independentes, ao contrário da geração anterior, proporcionando uma largura de banda de 64 bits.

Memória RIMM - RIMM é o nome patenteado para Direct Rambus Memory Module, sendo muito parecidos com as memórias DIMM, descritas acima. As principais diferenças estão no número de conectores e na transferência de dados, que ocorre a 16 bits. Entretanto, por possuir velocidade maior, era requerida uma lâmina de alumínio para refrigerar o equipamento.

Uma segunda definição, do Club do Hardwere, diz: Rambus In Line Memory Module - Módulo de Memória Rambus

Tipo de módulo de memória usado pelas memórias com tecnologia Rambus.

A tecnologia Rambus consiste em transmissões de poucos bits por vez (ex: 16 bits) porém com um clock muito elevado.

Os módulos RIMM são classificados da seguinte forma:

-

1ª geração (16 bits): PC600 ou RIMM 1200 (1.200 MB/s), PC700 ou RIMM 1400 (1.400 MB/s) e PC800 ou RIMM 1600 (1.600 MB/s).

-

2ª geração (32 bits): PC1066 ou RIMM 4200 (4.200 MB/s).

-

3ª geração (64 bits): PC1333 ou RIMM 11G (10,7 GB/s).

Só é possível instalar módulos RIMM em placas-mãe que aceitam este tipo de memória. São poucas as placas-mãe com este recurso.

Normalmente a configuração usada é de dois canais, fazendo com que a taxa de transferência seja o dobro da nominal caso sejam usados dois módulos. Por exemplo, em uma placa-mãe usando o chipset Intel 850 e com dois módulos PC800 instalados, a taxa de transferência da memória será de 3.200 MB/s (1.600 MB/s x 2), já que este chipset usa a configuração de dois canais.

Esta tecnologia necessita de terminação resistiva. Por este motivo, todos os soquetes RIMM da placa-mãe tem de obrigatoriamente estar preenchidos. No caso de não haver módulos de memória suficientes para preencher todos os soquetes, deve-se instalar um módulo chamado C-RIMM (Continuity RIMM), que é um módulo "vazio" responsável por fechar o circuito resistivo.

Memória DDR SDRAM

A Memória de Acesso Aleatório Dinâmica Síncrona de dupla taxa de transferência é uma das especificações de memória de maior sucesso na indústria, tendo sido desenvolvida com o objetivo de atingir o dobro do desempenho de sua antecessora. Considerando que os dados são transferidos a 64 bits por vez, a taxa de transferência (quando multiplicados a taxa de bus e o número de bits) chega a 1600 MB/s (leve em consideração que o valor normal seria de 800 MB/s, caso não houvesse a tecnologia de transmissão dupla).

DDR2 SDRAM

O principal padrão atual é uma evolução da memória tipo DDR convencional, contando com uma série de transformações nas especificações que visam o aumento de velocidade (incluindo o clock), a minimização do consumo de energia, do aquecimento e da interferência por ruídos elétricos e o aumento da densidade (mais memória total por pente ou chip).

DDR3 SDRAM

Assim como para a revisão anterior, a DDR3 tem como propósito elevar ainda mais o desempenho das memórias, reduzindo consumo e acelerando as capacidades de acesso e armazenamento de dados. A banda de transferência de dados é duas vezes superior a encontrada nas DDR2, entretanto, a latência se manteve praticamente idêntica. Vale ressaltar que este padrão de memória já está entrando em uso, com processadores como o Intel i7 e placas mãe específicas.

De quanto eu preciso?

Ao contrário do que muitos usuários acreditam, adicionar memória RAM nem sempre aumenta o desempenho do computador. Para entender melhor esta ideia, imagine que seu computador já conta com 1 GB de memória. Com base neste valor, pense que o sistema operacional consome cerca de 300 MB para rodar, que o navegador aberto ocupa mais 120 MB e que a sua planilha de Excel adiciona mais 100 MB na conta.

Teoricamente você teria memória de sobra para rodar mais alguns aplicativos (480 MB) e, caso não fosse abrir muitas coisas a mais, um pente adicional não causaria impacto, pois já há uma quantia livre mais que suficiente.

Em outra situação, mantenha o computador com 1 GB de RAM, mas imagine que o sistema operacional, navegador, planilha e mais alguns programas abertos consomem cerca de 900 MB de RAM. Com mais um joguinho leve ou uma aba extra com Flash no navegador você saltaria para cima de 1 GB de memória ocupado (tendo que recorrer à memória virtual, realizando a troca entre os aplicativos alocados na memória RAM e perdendo muito desempenho pelo meio do caminho).

É para este segundo caso que a adição de mais memória causa impacto, abrindo mais espaço para os programas e o sistema “respirarem”.

(Fontes: Baixaki e Club do Hardwere)

No dia a dia doméstico encontramos certas dificuldades em solucionar alguns problemas que aprecem, como: o entupimento de pias, o acendimento do fogo da churrasqueira, vazamento de torneiras, dentre outros impedimentos que entravam o andamento normal das rotinas diárias.

No dia a dia doméstico encontramos certas dificuldades em solucionar alguns problemas que aprecem, como: o entupimento de pias, o acendimento do fogo da churrasqueira, vazamento de torneiras, dentre outros impedimentos que entravam o andamento normal das rotinas diárias. Dica 2 – Quem nunca acendeu o fogo do fogão a lenha, do fogareiro ou da churrasqueira, desconhece o aborrecimento que dá, que estressa até os entes mais calmos, porque este insiste em não pegar, precisando ser abanado, soprado, estimulado com gravetos, papel, plástico, borracha, óleo, etc., e mesmo assim às vezes emperra e não se inflama.

Dica 2 – Quem nunca acendeu o fogo do fogão a lenha, do fogareiro ou da churrasqueira, desconhece o aborrecimento que dá, que estressa até os entes mais calmos, porque este insiste em não pegar, precisando ser abanado, soprado, estimulado com gravetos, papel, plástico, borracha, óleo, etc., e mesmo assim às vezes emperra e não se inflama.abaixo..

DIVULGAÇÃO DOS ÍNDICES DE ACIDENTALIDADE

DIVULGAÇÃO DOS ÍNDICES DE ACIDENTALIDADE

Aos quatro anos, Chico Xavier teve primeiro contato com os espíritos; na maturidade tornou-se o maior médium da história do Espiritismo brasileiro. Um resumo da emocionante história do homem que, ainda criança, se comunicava com espíritos e psicografava mensagens.

Aos quatro anos, Chico Xavier teve primeiro contato com os espíritos; na maturidade tornou-se o maior médium da história do Espiritismo brasileiro. Um resumo da emocionante história do homem que, ainda criança, se comunicava com espíritos e psicografava mensagens.  Em 29 de agosto de 1831, nasce no Ceará, Adolfo Bezerra de Menezes, um

Em 29 de agosto de 1831, nasce no Ceará, Adolfo Bezerra de Menezes, um Depois que Jesus exaltou o valor do amor ao próximo, narrando a Parábola do Bom Samaritano, partiu com os discípulos para a cidade de Betânia. No caminho, depois de profundas reflexões, João aproximou-se do Mestre e considerou:

Depois que Jesus exaltou o valor do amor ao próximo, narrando a Parábola do Bom Samaritano, partiu com os discípulos para a cidade de Betânia. No caminho, depois de profundas reflexões, João aproximou-se do Mestre e considerou:  " A ciência sem a religião é paralítica, e a religião sem a ciência é cega ". Albert Einstein

" A ciência sem a religião é paralítica, e a religião sem a ciência é cega ". Albert Einstein