-

O

método formalista mais antigo, entende que a obra de arte se dá pelas formas e sua compreensão também.

-

O método histórico entende que a obra de arte é um fato histórico, portanto reflexo e ação em um determinado contexto histórico.

-

O 'método sociológico entende a obra de acordo com o estudo da sociedade a qual ela pertence.

-

O método iconográfico entende a obra pelos ícones e símbolos que ela carrega.

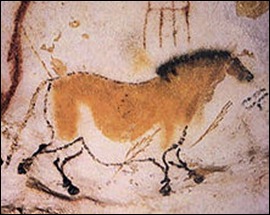

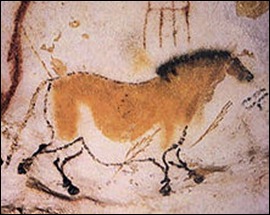

Se formos analisar a arte ao longo da história, podemos começar pela Arte da Pré-História, que é o período onde se mostram as primeiras demonstrações de arte que se tem notícia na história humana. Retratavam animais, pessoas, e até sinais. Havia cenas de caçadas, de espécies extintas, e em diferentes regiões. Apesar do desenvolvimentos primitivo, podem-se distinguir

diferentes estilos, como pontilhado (o contorno das figuras formado por pontos espaçados) ou de contorno contínuo (com uma linha contínua marcando o contorno das figuras). Apesar de serem

vistas como mal-feitas e não-civilizadas, as figuras podem ser consideradas um exemplo de sofisticação e inovação para os recursos na época. Não existem muitos exemplos de arte-rupestre preservada, mas com certeza o mais famoso deles é o das cavernas de Lascaux, na França.

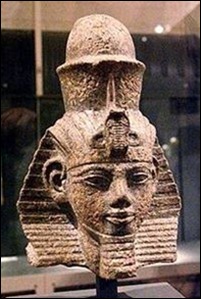

Se pularmos um bocado, chegaremos à Arte do Antigo Egipto, o palco para uma das mais interessantes descobertas do ser humano. A arte egípcia, à semelhança da arte grega, apreciava muito as cores. As estátuas, o interior dos templos e dos túmulos eram profusamente coloridos. Porém, a passagem do tempo fez com que se perdessem as cores originais que cobriam as superfícies dos objectos e das estruturas.

Os criadores do legado egípcio chegam aos nossos dias anónimos, sendo que só em poucos casos se conhece efectivamente o nome do artista. Tão pouco se sabe sobre o seu carácter social e pessoal, que se crê talvez nem ter existido tal conceito no grupo artístico de então. Por regra, o artista egípcio não tem um sentido de individualidade da sua obra, ele efectua um trabalho consoante uma encomenda e requisições específicas e raramente assina o trabalho final. Também as limitações de criatividade impostas pelas normas estéticas, e as exigências funcionais de determinado empreendimento, reduzem o seu campo de actuação individual e, juntamente com o facto de ser considerado um executor da vontade divina, fazem do artista um elemento de um grupo anónimo que leva a cabo algo que o transcende.

Os criadores do legado egípcio chegam aos nossos dias anónimos, sendo que só em poucos casos se conhece efectivamente o nome do artista. Tão pouco se sabe sobre o seu carácter social e pessoal, que se crê talvez nem ter existido tal conceito no grupo artístico de então. Por regra, o artista egípcio não tem um sentido de individualidade da sua obra, ele efectua um trabalho consoante uma encomenda e requisições específicas e raramente assina o trabalho final. Também as limitações de criatividade impostas pelas normas estéticas, e as exigências funcionais de determinado empreendimento, reduzem o seu campo de actuação individual e, juntamente com o facto de ser considerado um executor da vontade divina, fazem do artista um elemento de um grupo anónimo que leva a cabo algo que o transcende.

As grandes tradições na arte têm um fundamento na arte de uma das grandes civilizações antigas: Antigo Egito, Mesopotâmia, Pérsia, Índia, China, Grécia Antiga, Roma, ou Arábia (antigo Iêmen e Omã). Cada um destes centros de início civilização desenvolveu um estilo único e característico de fazer arte. Dada a dimensão e duração dessas civilizações, mais das suas obras de arte têm sobrevivido e mais da sua influência foi transmitida a outras culturas e tempos mais tarde. O período da arte grega viu uma veneração da forma física humana e o desenvolvimento de competências equivalentes para mostrar musculatura, pose, beleza e anatomia em geral.

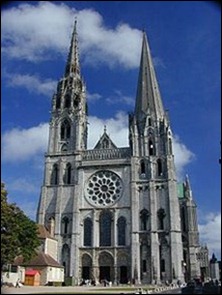

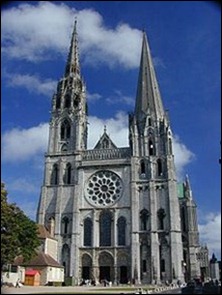

A arte gótica surgiu tempos depois, já na Arte pré-românica. Os monumentos construídos nessa época marcaram todo um modo especial de criar arquitetura e desenvolveu métodos preciosos e estilos definidos como sombrios e macabros.

A arte gótica surgiu tempos depois, já na Arte pré-românica. Os monumentos construídos nessa época marcaram todo um modo especial de criar arquitetura e desenvolveu métodos preciosos e estilos definidos como sombrios e macabros.

A Arte Bizantina e a gótica da Idade Média ocidental, mostraram uma arte que centrou-se na expressão das verdades bíblicas e não na materialidade. Além disto, enfatizou métodos que mostram a glória em mundos celestes, utilizando o uso de ouro em pinturas, ou mosaicos.

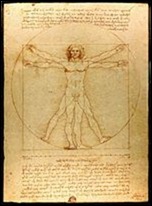

A Renascença ocidental deu um retorno à valorização do mundo material, bem como o local de seres humanos, e mesmo essa mudança paradigmática é refletida nessa arte, o

que mostra a corporalidade do corpo humano, bem como a realidade tridimensional da paisagem.

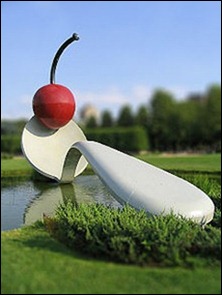

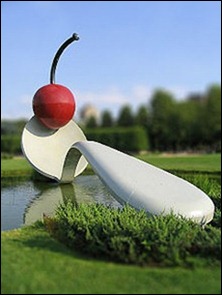

A pop art é completamente caracterizada como algo de humor e muito diferente da arte antiga, pois retrata, de maneira irônica, o que utilizamos nos dias de hoje, só que com outros tamanhos, ambientes e formas.

A pop art é completamente caracterizada como algo de humor e muito diferente da arte antiga, pois retrata, de maneira irônica, o que utilizamos nos dias de hoje, só que com outros tamanhos, ambientes e formas.

Os ocidentais do Iluminismo no século 18 faziam representações artísticas de modo físico e racional sobre o Universo, bem como visões de um mundo pós-monarquista, como a pintura que William Blake fez de um Newton divino. Isto reforçou a atenção ao lado emocional e à individualidade dos seres, exemplificados em muitos romances de Goethe. O século 19, em seguida, viu uma série de movimentos artísticos, tais como arte acadêmica, simbolismo, impressionismo, entre outros.

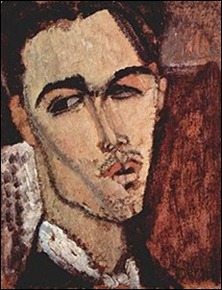

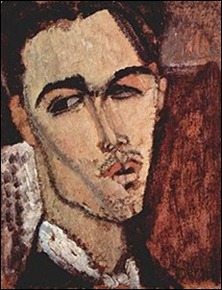

O aumento de interação global durante este tempo fez uma grande influência de outras culturas na arte ocidental, como Pablo Picasso sendo influenciado pela cultura da África. Do mesmo modo, o Ocidente tem tido enorme impacto sobre arte oriental no século XIX e no século XX, com ideias ocidentais originalmente como comunismo e Pós-Modernismo exercendo forte influência sobre estilos artísticos.

O Modernismo baseou-se na ideia de que as formas "tradicionais" das artes plásticas, literatura, design, organização social e da vida cotidiana tornaram-se ultrapassados, e que fazia-se fundamental deixá-los de lado e criar no lugar uma nova cultura. Esta constatação apoiou a ideia de re-examinar cada aspecto da existência, do comércio à filosofia, com o objetivo de achar o que seriam as "marcas antigas" e substituí-las por novas formas, e possivelmente melhores, de se chegar ao "progresso". Em essência, o movimento moderno argumentava que as novas realidades do século XX eram permanentes e iminentes, e que as pessoas deveriam se adaptar as suas visões-de-mundo a fim de aceitar que o que era novo era também bom e belo. No modernismo, surgiu vários estilos, os mais destacados são Expressionismo, Simbolismo, Impressionismo, Realismo, Naturalismo, Cubismo e Futurismo, embora tenham sido desenvolvidos diversos outros.

Características

A arte tende a facilitar a compreensão intuitiva, em vez de racional, e normalmente é, conscientemente, criada com esta intenção. As obras de arte são imperceptíveis, escapam de classificação, porque elas podem ser apreciadas por mais de uma interpretação.

Tradicionalmente, os maiores sucessos artísticos demonstram um alto nível de capacidade ou fluência dentro de outras obras, por isso se destacam.

A arte pode utilizar a imagem para comover, emocionar, conscientizar; ou palavras profundas para se apaixonar por um certo poema ou livro. Basicamente, a arte é um ato de expressar nossos sentimentos, pensamentos e observações. Existe um entendimento de que é alcançado com o material, como resultado do tratamento, o que facilita o seu processo de entendimento.

Uma escultura do Antigo Egito: Note que o artista precisou utilizar uma percepção da forma que iria fazer para a obra sair com o resultado de um rosto.

Uma escultura do Antigo Egito: Note que o artista precisou utilizar uma percepção da forma que iria fazer para a obra sair com o resultado de um rosto.

A opinião comum diz que para se fazer uma arte que tenha como resultado uma obra de qualidade, é preciso uma especialização do artista, para ele alcançar um nível de conhecimento sobre a demonstração da capacidade técnica ou de uma originalidade na abordagem estilística. Notamos nas peças de Shakespeare uma profunda análise de psicologia sobre os personagens, como em Hamlet.

As críticas quanto à algumas obras, deve-se muitas vezes, segundo o crítico, à falta de habilidade ou capacidade necessária para a produção do objeto artístico. Habilidade e capacidade necessária para a produção do tal objeto são dois itens completamente importantes. No entanto, é importante definir que nem toda obra de arte vale através da arte. Vemos, como exemplo, a obra My Bed, da artista britânica Tracey Emin. A cama demonstra desorganização. A artista usou pouco ou nenhum reconhecido tradicional de conjunto de competências, embora tenha demonstrado uma nova habilidade (diferente do mais comum, que seria uma cama arrumada).

A montagem dos materiais de uma obra requer técnica e criatividade e também conhecimento. Um exemplo é um dramaturgo ter em mente que o material que usará para criar sua peça de teatro será a palavra e um aprofundamento sobre as personagens, o enredo e etc. Depois disto, basta usar toda sua criatividade e conhecimento para ir moldando o texto da peça.

Estética

A beleza de uma obra torna-a mais destacada quando é comparada às outras. O material usado pelo artista e suas técnicas são o que tornam uma obra de arte bonita, com uma boa aparência. Entretanto, é importante destacar novamente a obra My Bed, de Tracey Emin, onde a cama não possui uma beleza comum, embora apresente uma situação.

A estética é fundamental numa obra de arte. Vemos como exemplo a arquitetura com seus edifícios majestosos, grandes, esbeltos, o que faz com que as pessoas admirem. Assim é também com um bom conto, em questão de literatura, e com uma boa pintura. Como já foi falado, o material usado é o que irá mostrar a beleza da arte.

É importante ter um estudo mais profundo sobre a estética. Conseguimos isso separando quais conceitos formam a estética, a começar pela beleza. A beleza é uma percepção individual caracterizada normalmente pelo que é agradável aos sentidos. Esta percepção depende do contexto e do universo cognitivo do indivíduo que a observa. O belo depende muito da sociedade e de suas crenças. Um exemplo disto é o quadro Abaporu, de Tarsila do Amaral. Para ela, a figura do quadro era um monstro e para a maioria das pessoas. Mas por quê? Será que por que não corresponde ao padrão de beleza da nossa sociedade? Na época de Leonardo da Vinci, as mulheres eram tidas bonitas quando eram rechonchudas. Exemplo disto é a Mona Lisa.

Outro aspecto da estética é o equilíbrio. O equilíbrio se encontra quando todos os elementos que compõe a imagem estão organizados de tal forma que nada é enfatizado, todos passando uma sensação de equilíbrio visual. O equilíbrio é mais utilizado nas pinturas. O que influencia o equilíbrio são as cores, as imagens, as superfícies, os tamanhos e as posições dos itens presentes na pintura, ou numa outra arte plástica. Reflita sobre um quadro cujo desenho seja um horizonte, o pôr do sol e um lindo mar refletindo a luz alaranjada do sol. No fundo do mar,

há um enorme navio, quase ocupando todo o espaço do quadro. Esta figura, o navio, dá ou não dá equilíbrio à pintura como um todo? Se não, o que seria necessário fazer para dar mais equilíbrio? Por qual motivo a figura do navio é enorme?

Harmonia é relacionada à beleza, à proporção e também à ordem. Um exemplo, é a música: todos os ritmos precisam estar bem delineados, bem ordenados para que haja uma harmonia, uma beleza no som. Quanto ao design, podemos definir harmonia como efeito da composição de formas, não de maneira aleatória, mas de modo que contornos e enchimentos sejam bem definidos, variando segundo um grau de importância pré-estabelecido e se relacionando ao esquema geral da organização do objeto. Este objeto pode ser um quadro, um site, enfim, qualquer entidade que esteja sendo composta por partes (engrenagens) menores.

Na escultura e na arquitetura, a forma também é uma das coisas mais importantes. Nas esculturas de Michelangelo, ou nas de Rodin, como, por exemplo, Davi, notamos que é um ser ali esculpido e este ser possui um corpo. Portanto, a forma do corpo precisa ser bem definida, bem adquirida para que se assemelhe a um corpo humano. No entanto, se o escultor for esculpir um monstro, como exemplo, é preciso haver a mesma coisa, embora ele tenha em mente um corpo totalmente diferente do comum.

O que define uma obra como esteticamente bonita e importante, além dos recursos que fora usado nela e de suas técnicas, é também seu valor, o que veremos a seguir.

Valor

Uma outra característica da arte é o valor[1]. Esta vem depois de sua realização pelo artista. É quando já está exposta ao público. Aqui, não é discutido especialmente a estética, e sim o valor relacionado a importância da obra, segundo a maioria. Podemos exemplificar esse raciocínio com a seguinte pergunta: por qual motivo o quadro Mona Lisa tem um grande valor? Ou até mesmo: por que as obras de Shakespeare são tão famosas e tidas como as melhores do mundo? E até: por que várias músicas do Beatles são tão prestigiadas?

Para começar, é importante relacionar quais elementos tornam uma obra de arte tão glamurosa. Quanto à Mona Lisa e as peças de Shakespeare, podemos notar algo semelhante: um elemento novo até então. Por exemplo: na Mona Lisa, há o sfumato. Nas peças mais famosas de Shakespeare, há técnicas ímpares para o teatro, como, p. exemplo, em Hamlet: o teatro no teatro. As músicas dos Beatles possuem ritmos e melodias pioneiros. Mas será que é apenas um elemento novo que faz uma obra ficar em destaque?

Além da distribuição e divulgação de uma obra, coisas que contribuem bastante para a sua fama, há também um outro item: a forma como a obra é criada e, assim, como ela sobrevive depois de anos. Este item é mais aplicado na literatura, onde diversos romances permanecem prestigiados mesmo depois de muito tempo escritos, por terem um valor social e emocional ainda muito presente no ser humano, como as peças de Shakespeare.

Além disto tudo, quando uma obra influencia outras por conter coisas novas e quando essa mesma obra possui aspectos que atraiam o espectador por algum motivo (seja motivacional, de reflexão, ou outro), ela então se torna valiosa pelos que gostaram.[2]

Ver também

Bibliografia

Referências

-

-

Ligações externas

Aos quatro anos, Chico Xavier teve primeiro contato com os espíritos; na maturidade tornou-se o maior médium da história do Espiritismo brasileiro. Um resumo da emocionante história do homem que, ainda criança, se comunicava com espíritos e psicografava mensagens.

Aos quatro anos, Chico Xavier teve primeiro contato com os espíritos; na maturidade tornou-se o maior médium da história do Espiritismo brasileiro. Um resumo da emocionante história do homem que, ainda criança, se comunicava com espíritos e psicografava mensagens.  Em 29 de agosto de 1831, nasce no Ceará, Adolfo Bezerra de Menezes, um

Em 29 de agosto de 1831, nasce no Ceará, Adolfo Bezerra de Menezes, um Depois que Jesus exaltou o valor do amor ao próximo, narrando a Parábola do Bom Samaritano, partiu com os discípulos para a cidade de Betânia. No caminho, depois de profundas reflexões, João aproximou-se do Mestre e considerou:

Depois que Jesus exaltou o valor do amor ao próximo, narrando a Parábola do Bom Samaritano, partiu com os discípulos para a cidade de Betânia. No caminho, depois de profundas reflexões, João aproximou-se do Mestre e considerou:  " A ciência sem a religião é paralítica, e a religião sem a ciência é cega ". Albert Einstein

" A ciência sem a religião é paralítica, e a religião sem a ciência é cega ". Albert Einstein