Continuação…

4ª Parte - 1ª Etapa

4) Boot só funciona por disquete, mas HD está OK

4) Boot só funciona por disquete, mas HD está OK

Este é um caso mais simples do item anterior. Não conseguimos executar o boot através do disco rígido, em geral é apresentada a mensagem NO ROM BASIC, mas o boot funciona através de disquete, e ao usarmos o comando DIR C:, o disco rígido parece normal. Tudo o que precisamos fazer é executar o programa FDISK e usar o comando 2 – Ativar partição ativa. Tornamos ativa a partição primária, e depois disso poderemos executar um boot pelo disco rígido.

5) Teclado trocando caracteres

O problema pode ser um defeito no teclado, e a substituição por um novo será a solução. Se o problema persistir mesmo com um teclado bom, então provavelmente está localizado na interface de teclado. Nos PCs atuais esta interface está localizada no Super I/O, portanto em caso de defeito na interface a placa de CPU estará perdida. Uma solução é utilizar um teclado USB, deixando de lado a interface de teclado comum. Em PCs antigos, esta interface é formada pelo chip 8042, sobre o qual existe normalmente uma etiqueta com a indicação Keyboard BIOS. Experimente instalar no seu lugar, o 8042 retirado de uma outra placa de CPU. Este chip pode ser obtido em sucatas de peças para PC. Uma placa de CPU estragada chega a custar de 10 a 20 reais, e dela podemos extrair algumas peças, inclusive o 8042.

Soluções paliativas para problemas com o teclado:

Se o seu teclado às vezes fica maluco e troca caracteres mas você ainda não teve tempo para resolver o problema, existe um pequeno macete. Pressione simultaneamente as duas teclas SHIFT, e o teclado voltará ao normal (pelo menos por enquanto). Se o seu PC fica aparentemente travado no início do boot, logo depois do teste de memória, pressione a barra de espaço.

6) “Keyboard Error” durante o boot

Ao ser ligado o computador, logo depois do POST e antes do carregamento do sistema operacional, pode aparecer a mensagem:

Keyboard Error – Press <F1> to continue

Esta mensagem pode ocorrer pelo fato do teclado estar defeituoso, mas normalmente ocorre quando a rotina de teste de teclado do POST é feita antes que o microprocessador existente dentro do teclado realize a sua inicialização. Para evitar este problema, procuramos no Standard CMOS Setup o comando Keyboard e o programamos como Disabled. Isto significa que o teclado não será testado durante o POST, e desta forma o erro será eliminado. Outra forma de evitar este problema é comandar um teste de memória mais demorado. Habilite a opção Above 1 MB Memory Test e desabilite a opção Quick Boot ou Quick Power on Self Test. Isto dará tempo ao chip do teclado para fazer sua inicialização, eliminando o problema.

7) Sistema operacional inválido

Esta é uma mensagem de erro que ocorre quando alguns dos arquivos envolvidos no boot estão em falta, ou quando existe algum problema no setor de boot. Quando isto ocorre, conseguimos executar um boot através de um disquete e acessar o drive C, porém o boot pelo drive C não funciona. Para resolver este problema é preciso executar um boot com um disquete contendo o programa SYS.COM. Deve ser da mesma versão que a existente no disco rígido. Use o comando:

SYS C:

Os arquivos necessários para o boot serão copiados do disquete para o drive C. Feito isto, já será possível executar um boot pelo drive C.

Este problema também ocorre quando os parâmetros do disco rígido no CMOS Setup são alterados depois que o sistema operacional já está instalado.

8) HDD Controller Failure

Significa “Falha na controladora do disco rígido”. Esta mensagem de erro ocorre durante o POST quando é detectado algum problema no acesso ao disco rígido. Ao contrário do que muitos pensam, este problema não está necessariamente na interface IDE. Pode estar no próprio disco rígido. As suas causas possíveis são:

· O disco rígido, ou a interface IDE, ou o cabo flat está defeituoso

· O disco rígido não está declarado no CMOS Setup

· O disco está com parâmetros errados no CMOS Setup

· Existe erro na configuração de jumpers do disco rígido

No item 3 desta seção já apresentamos os procedimentos a serem usados para checar cada um desses pontos. Se mesmo com essas checagens o problema persistir, existe grande chance do disco rígido, ou a sua interface, ou o cabo flat estar defeituoso. A melhor coisa a fazer é tentar substituições até descobrir a causa do problema.

9) FDC Controller Failure

Significa “Falha na controladora de drives de disquete”. Esta é outra mensagem que pode aparecer durante o POST. O erro pode ter várias causas:

· Erro na declaração dos drives de disquete no CMOS Setup

· Conexões frouxas no drive ou na interface

· Conexão errada no cabo flat para drives

· Drive de disquetes defeituoso

· Cabo flat defeituoso

· Interface para drive de disquetes defeituosa

· Problema na fonte de alimentação ou no seu conector

Note que o fato do drive passar pelo POST sem erros não significa que esteja em boas condições. O erro apresentado no POST indica apenas que ocorreu falha na comunicação com o drive de disquetes. Neste teste, nem mesmo uma leitura é feita no disquete, apenas é ligado o seu motor e feito um movimento com as cabeças de leitura e gravação.

CMOS Setup - Comece checando se o drive de disquetes está declarado corretamente no CMOS Setup. Verifique no Standard CMOS Setup como os drives estão programados. Em um PC com apenas um drive de 1.44 MB, deve estar declarado A=1.44 MB e B=None.

Cabo flat e cabo da fonte - Verifique se o cabo flat está conectado corretamente na interface para drives e no próprio drive, e se o conector da fonte de alimentação está ligado corretamente no drive. Quando o cabo flat dos drives está invertido, esta mensagem de erro também aparece. Nesse caso o LED do drive fica permanentemente aceso. Normalmente esta inversão não danifica o drive nem sua interface. Basta corrigir a conexão e o drive voltará a funcionar.

Defeito - Finalmente, pode existir um defeito no drive, na interface para drives ou no próprio cabo. Para tirar a dúvida temos que fazer substituições. É bom que o problema esteja no drive, ou então no cabo flat. Desta forma o custo da reposição será mais baixo.

O defeito em uma interface para drives localizada em uma placa de CPU pode ser solucionado, sem a necessidade de trocar a placa. Devemos para isto instalar uma placa IDEPLUS de 16 bits para utilizar a sua interface de drives. Todas as demais interfaces desta placa IDEPLUS devem ser desabilitadas através de seus jumpers. A interface IDE da placa de CPU deve ser desabilitada na seção Peripheral Configuration do CMOS Setup. Desta forma o drive de disquetes poderá ser ligado na placa IDEPLUS, e a placa de CPU poderá ser aproveitada.

10) Mouse inativo

Muitos são os problemas que podem levar o mouse a não funcionar. Essa inatividade é representada pela ausência do cursor do mouse na tela, ou então por um cursor imóvel. Aqui estão algumas causas possíveis.

Mouse defeituoso

Interface para mouse defeituosa

Fonte de alimentação defeituosa (sem tensões de +12 e –12 volts)

A interface do mouse pode estar desabilitada

Erro na conexão entre a placa de CPU e o conector da interface do mouse

Uso de conectores de outra placa

Conflito de hardware

Mouse ligado na COM2, no modo MS-DOS

Troca simples - Muitos modelos de mouse têm baixa qualidade, e podem realmente apresentar defeito com relativa facilidade. Como o mouse é muito suspeito, é aconselhável tentar antes substituí-lo por um mouse em boas condições, ou então instalar o mouse suspeito em outro computador para verificar o seu funcionamento.

Software de diagnóstico - A interface na qual o mouse está conectado (COM1, COM2 ou interface para mouse PS/2) pode estar defeituosa. Podemos checar o seu funcionamento usando um programa de diagnóstico. Devemos acoplar o conector loopback na porta serial para fazer o teste completo. Quando um erro é apresentado, é possível que não seja exatamente na interface serial, mas no cabo que liga a interface serial até o seu conector na parte traseira do PC. No caso de placas AT, o conector do mouse é separado da placa, e ligado através de um cabo auxiliar. Este cabo pode estar mal conectado, ou então conectado de forma invertida, ou mesmo defeituoso. É possível ainda que esteja sendo usado o cabo de uma outra placa de CPU, incompatível com a placa atual. Esses cabos não são padronizados, e o cabo que acompanha uma placa não necessariamente funcionará com outras placas.

Teste em outra porta - Para verificar se o problema está na porta serial, podemos tentar ligar o mouse em outra porta. Se o mouse está na COM1, ligue-o na COM2. O Windows reconhecerá automaticamente a porta onde o mouse está ligado e aceitará os seus comandos. Tome cuidado com o caso do mouse padrão PS/2. A maioria das placas de CPU atuais possuem uma interface para mouse padrão PS/2. Essa interface não é uma COM1 nem COM2, e normalmente utiliza a IRQ12. Precisa ser habilitada no CMOS Setup para que funcione. Procure no Peripheral Configuration o item Mouse function e habilite-o.

Conflito de hardware - Quando a interface na qual está ligado o mouse entra em conflito de hardware com outra interface, o mouse apresentará funcionamento errático, ou simplesmente travará. O caso mais comum é quando o mouse está usando COM1/IRQ4 e o modem está configurado como COM3/IRQ4. É preciso reconfigurar os endereços e IRQs dos dispositivos envolvidos para desfazer o conflito de hardware. Observe que a interface para mouse padrão PS/2 também pode apresentar conflito, caso outra interface esteja também usando a IRQ12. Use o Gerenciador de Dispositivos para verificar possíveis conflitos de hardware.

Driver para MS-DOS - Se o mouse funciona no Windows e não funciona no modo MS-DOS, temos aqui outro problema típico. Para que o mouse funcione em modo MS-DOS é preciso que seja executado o seu driver, normalmente um programa com o nome MOUSE.COM, GMOUSE.COM, MMOUSE.COM ou similar. Outra questão a ser verificada é a ligação do mouse na COM2. No Windows o mouse funciona automaticamente, tanto na COM1 como na COM2. No caso do modo MS-DOS, é preciso avisar ao driver do mouse, qual é a porta serial usada. Use o programa de driver do mouse com o parâmetro /? ou /H e serão apresentadas instruções para que o mouse funcione na COM2.

11) Imagem sem sincronismo, desde que o PC é ligado

A imagem do monitor fica rolando na tela, totalmente distorcida e na maioria das vezes impossível de ler. Quando este problema ocorre apenas no Windows ou quando é ativado algum modo gráfico de alta resolução, não se trata de um defeito, mas de um erro na programação da placa de vídeo. Por outro lado, quando desde o instante em que o PC é ligado a imagem fica instável, provavelmente temos um problema sério:

· Monitor defeituoso

· Cabo de vídeo defeituoso

· Placa de vídeo defeituosa

Você pode fazer substituições usando outro computador, e fatalmente encontrará a causa do problema. Se o defeito estiver no cabo você poderá consertá-lo, ou então adquirir um cabo novo, o que dá muito menos trabalho. O monitor defeituoso deve ser enviado a uma assistência técnica especializada neste tipo de conserto. Uma placa de vídeo defeituosa poderá ser simplesmente trocada.

12) Imagem sem sincronismo no Windows

Quando o monitor apresenta imagens perfeitas durante o processo de boot, mas fica fora de sincronismo quando é iniciado o Windows, ou então quando é executado algum programa gráfico que use imagens de alta resolução, não existe defeito algum, nem no monitor, nem no cabo, nem na placa de vídeo. O problema está nas freqüências horizontais usadas pela placa de vídeo, por estarem acima dos valores permitidos pelo monitor. É preciso portanto ajustar as freqüências da placa de vídeo para que se tornem compatíveis com as do monitor. Com este pequeno ajuste, o problema de falta de sincronismo estará solucionado. O ajuste é feito através do quadro de configurações de vídeo.

Aos quatro anos, Chico Xavier teve primeiro contato com os espíritos; na maturidade tornou-se o maior médium da história do Espiritismo brasileiro. Um resumo da emocionante história do homem que, ainda criança, se comunicava com espíritos e psicografava mensagens.

Aos quatro anos, Chico Xavier teve primeiro contato com os espíritos; na maturidade tornou-se o maior médium da história do Espiritismo brasileiro. Um resumo da emocionante história do homem que, ainda criança, se comunicava com espíritos e psicografava mensagens.  Em 29 de agosto de 1831, nasce no Ceará, Adolfo Bezerra de Menezes, um

Em 29 de agosto de 1831, nasce no Ceará, Adolfo Bezerra de Menezes, um Depois que Jesus exaltou o valor do amor ao próximo, narrando a Parábola do Bom Samaritano, partiu com os discípulos para a cidade de Betânia. No caminho, depois de profundas reflexões, João aproximou-se do Mestre e considerou:

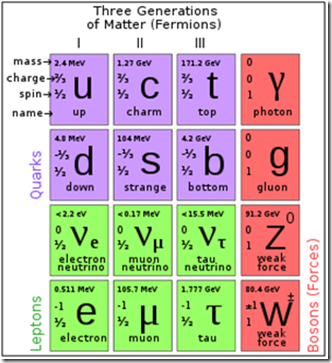

Depois que Jesus exaltou o valor do amor ao próximo, narrando a Parábola do Bom Samaritano, partiu com os discípulos para a cidade de Betânia. No caminho, depois de profundas reflexões, João aproximou-se do Mestre e considerou:  " A ciência sem a religião é paralítica, e a religião sem a ciência é cega ". Albert Einstein

" A ciência sem a religião é paralítica, e a religião sem a ciência é cega ". Albert Einstein